NOUVELLES

L’intelligence artificielle, entre promesses et craintes

[ad_1]

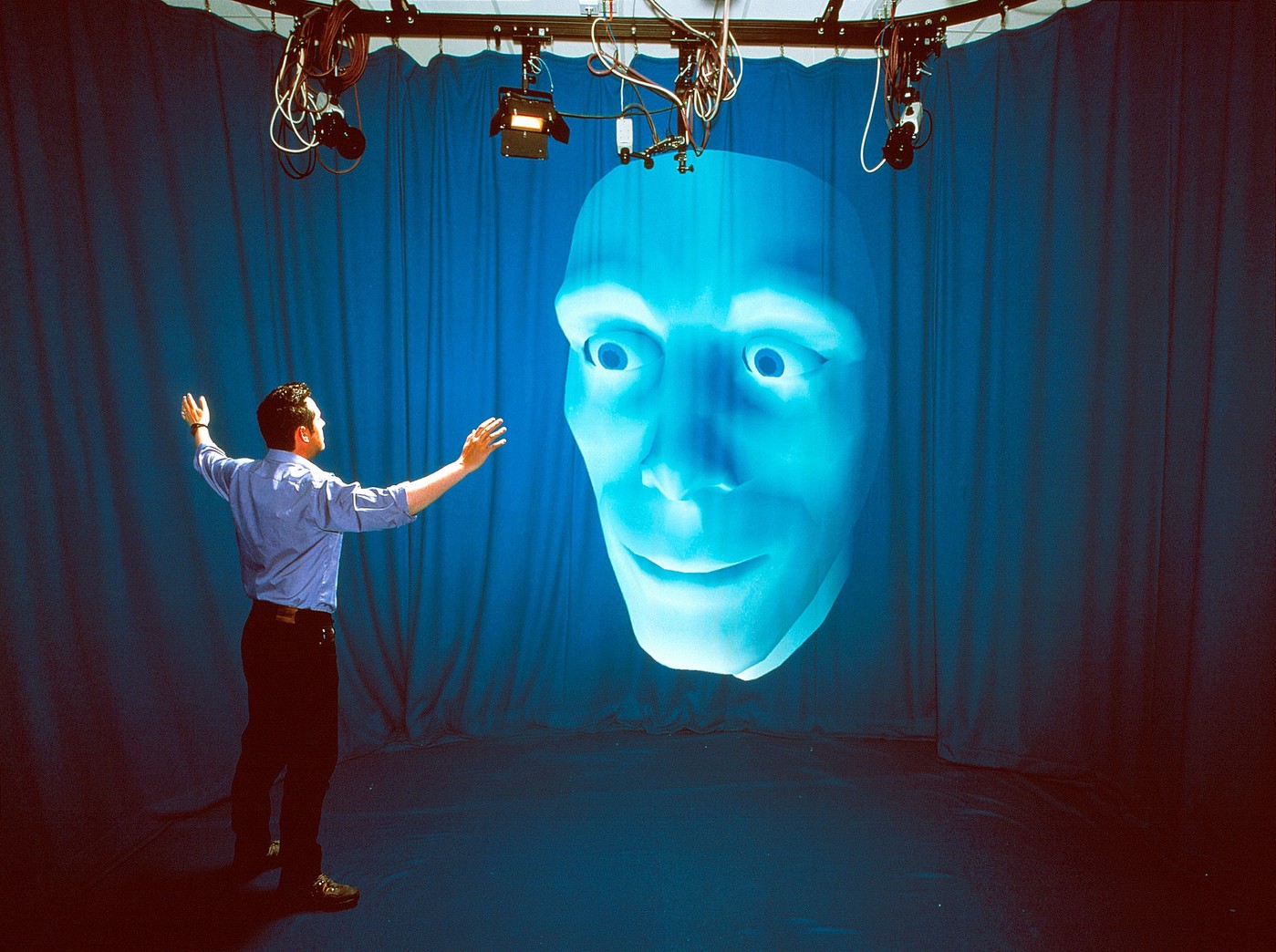

L’intelligence artificielle (IA) ne laisse personne indifférent, que l’on imagine un monde idéal où les travaux pénibles reviendraient à des robots ou bien un contrôle dictatorial par des androïdes. « L’IA n’est pas un mot magique que l’on doit employer dans tous les sens, tranche Isabelle Ryl, à la tête de l’institut Prairie, spécialisé en intelligence artificielle. C’est un outil. Un outil performant, certes, mais rien de plus aujourd’hui. »L’intelligence artificielle n’est, pour l’instant encore, ni plus ni moins qu’un ordinateur qui réalise des fonctions effectuées par des humains comme celles de reconnaître des éléments sur une image ou de répondre à une question orale. Mais, avec le développement du deep learning (voir lexique page suivante), le domaine a connu un développement sans précédent. Aujourd’hui, une IA sait identifier des chiens et des chats, recommander un plombier, éviter une collision en voiture, retoucher une photographie, détecter des tumeurs cancéreuses… Couplée à un robot, elle sait ouvrir des portes, soulever des charges lourdes ou sauter par-dessus des obstacles. Bonne à tout faire ? Non.« Pour l’instant, les IA ne sont pas autonomes », rappelle Jean-Claude Heudin, chercheur en IA et auteur de Intelligence artificielle. Manuel de survie. « Pour mettre au point ces machines, rassembler et préparer les données nécessaires, il faut des interventions humaines », souligne-t-il. La plupart des IA suivent un « apprentissage supervisé ». Cela revient à leur montrer des milliers de photos indiquant « ça c’est un vélo, ça c’est un piéton », pour qu’ensuite, face à une photo, l’IA sache distinguer un piéton et un vélo. « C’est nettement moins performant que notre cerveau qui n’a pas besoin de millions d’images pour apprendre la différence ! », relativise Jean-Claude Heudin.C’est aussi monomaniaque : « Une IA entraînée à détecter des tumeurs du foie sur une radiographie ne saura pas le faire pour des tumeurs des poumons, et pourra encore moins identifier des troupeaux d’éléphants dans des images satellites », pose Isabelle Ryl. La technologie de reconnaissance d’images est la même, mais l’entraînement diffère grandement. Attention, enfin, aux biais. Une IA qui classe des CV d’ingénieurs ne doit pas écarter les femmes sous prétexte que c’est un métier où elles sont sous-représentées et reproduire les biais sexistes ou racistes de la société.Autre possibilité, l’apprentissage par renforcement. Par exemple, pour être imbattable aux échecs, une IA commence par perdre beaucoup de parties. Elle apprend de ses erreurs, dans des proportions démesurées. Surtout, les machines n’ont pas conscience d’elles-mêmes ni du monde qui les entoure, ce qui oblige à plus d’essais. « Un être humain qui passe son permis de conduire n’a pas besoin de passer la voiture par-dessus la falaise pour savoir que c’est une mauvaise idée. Un ordinateur aura besoin de le simuler, car il ne fait pas le lien falaise = tomber = danger », compare Isabelle Ryl.« Depuis le premier réseau de neurones artificiels, le perceptron de l’Américain Frank Rosenblatt en 1958, cette technologie a gagné en performance mais reste très simple comparée à notre cerveau », explique Jean-Claude Heudin. Pour effectuer le « bond » suivant, beaucoup de recherches s’orientent désormais sur la façon dont les enfants apprennent pour créer une représentation globale du monde.

[ad_2]

Ссылка на источник